我们搭建好一个网站,搜索引擎爬取我们页面的工具叫做搜索引擎机器人,也就是所谓的“蜘蛛”,蜘蛛在爬取网站页面之前,会先去访问网站根目录下面的一个文件,这个文件其实就是给“蜘蛛”的规则,也就是robots.txt,如果没有这个文件,蜘蛛会认为你的网站同意抓取全部网页。

这样就会为日后的运营,埋下隐患,比如:

1,新站无栏目无内容,被收录,影响站点质量评定;

2,产生大量重复页面,动态链接被抓取。

robots.txt文件是一个纯文本文件,如果网站根目录有这个文件,那么就可以告诉蜘蛛哪些页面可以爬取(收录),哪些页面不能爬取。

例如:建立一个名为robots.txt的文本文件,然后输入内容

User-agent: //*星号说明允许所有搜索引擎收录 Disallow: index.php? //表示不允许收录以index.php?前缀的链接,比如index.php?=1 Disallow: /zb_system/ //表示不允许收录根目录下的zb_system目录,包括目录下的文件,比如zb_system/232.html

具体关于robots.txt文件的相关设置,你可以参考百度官方文档,百度搜索资源平台->网站支持->数据监控->robots

那么针对于zblogphp网站的robots.txt该怎么写呢?

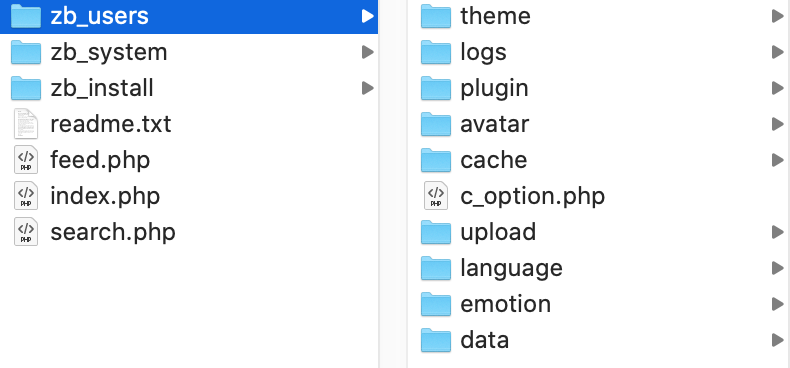

首先我们来看zblogPHP的目录结构

zblog网站系统根目录

feed.php : RSS Feed 入口文件

index.php : 前端页面入口文件

search.php : 搜索入口文件

zb_install 文件夹:zblog系统安装文件夹,安装完毕会自动删除,或手动删除

zb_system 文件夹:为 zblog系统框架的主要文件(屏蔽蜘蛛)

zb_users 文件夹:为 zblog为用户文件夹,里面包含了主题文件夹,插件文件夹,以及附件存放文件夹。

zb_users目录

theme :主题模版文件夹

logs :目志文件夹,里面文件是记录错误的(屏蔽蜘蛛)

plugin :插件文件夹

avatar :用户头像文件夹

cache :缓存文件夹

c_option.php :数据库配置文件

emotion :表情文件夹

upload :附件存放文件夹

language :语言包文件夹(屏蔽蜘蛛)

data :数据文件夹(屏蔽蜘蛛)

根据ZblogPHP的目录结构,zblogphp站点的robots.txt文件,可以写成这样:

User-agent: * Disallow: search.php Disallow: /zb_system/ Disallow: /zb_users/data/ Disallow: /zb_users/language/ Disallow: /zb_users/logs/ Sitemap:https://www.umtheme.com/sitemap.xml

其中网址www.umtheme.com换成你自己的域名,写好后把文件存放或上传到网站根目录即可,sitemap.xml可以通过插件生成,应用中心有专门的插件。

umtheme

umtheme